Evolución de los sistemas de codificación

Uno de los primeros sistemas de codificación de textos escritos es el código morse de 1835, que era un sistema en que cada carácter se codificaba con un número diferente de pulsos largos y cortos. Conocidos como puntos y rallas.

Esta codificación era usado por la telegrafía.

Una evolución de ello fue el sistema baudot de 1874, que codificaba cada carácter con cinco valores de carácter binario. Esto permitía 32 caracteres distintos (25), lo que no permitía acoger a todas las letras y los números (las 26 letras más las 10 cifras).

Por ello, su inventor Émile Baudot, diseñó un par de códigos especiales para saber si en los códigos siguientes se hacía referencia a la tabla de letras o a la de números.

Era utilizado en los teletipos (también llamados telex)

En 1963 el Comité Estadounidense de Estándares (conocido desde 1969 como el Instituto Estadounidense de Estándares Nacionales, o ANSI) creó el ASCII (American Standard Code for Information Interchange) que codificaba los caracteres el alfabeto latino con 7 bits de longitud (del 0 al 127).

Más tarde, en 1967, se incluyeron las minúsculas, y se redefinieron algunos códigos de control para formar el código conocido como US-ASCII.

Ello, de forma colateral, supuso un problema para la ordenación, puesto que la "Z" precede a la "a".

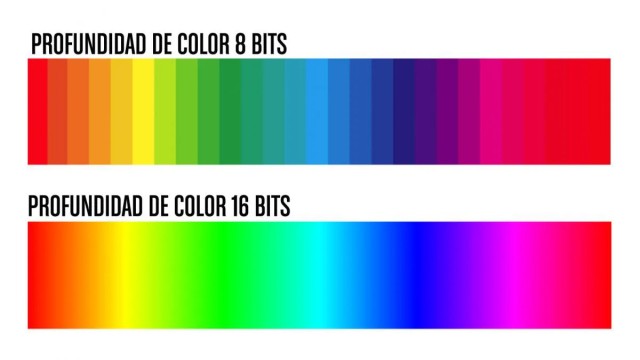

Posteriormente, con la codificación de 8 bits se incluyeron caracteres de lo que se conocía como "ASCII Extendido". Estos caracteres eran diferentes para cada lengua, incluyendo los caracteres específicos de cada país (como las vocales acentuadas o la "ñ").

La norma establecida por la Organización Internacional de Normalización que incluía los caracter del español era la ISO 8859-1 (Europa occidental). También conocida como Latin1.

En los sistemas Windows nos correspondía el juegos de caracteres Windows-1250.

Antes ya existía un estandard de 8 bits, usado por los ordenadores mainframe IBM, llamado EBCDIC. Que era la codificación de tarjetas perforadas en los años 1960.

Ante la problemática que suponía la disparidad de caracteres del "ASCII Extendido" utilizado por cada lengua/fabricante Unicode crea el Conjunto de Caracteres Universal, que permite codificar caracteres con bloques de más de 8 bits (ya sea de tamaño fijo, o de forma más eficiente de tamaño variable).

Por compatibilidad se conservan iguales la codificación de los primeros 128 caracteres con su antecesor ASCII.

La popular codificación UTF-8 emplea de uno a cuatro valores de 8 bits para cada carácter, donde los primeros 128 valores apuntan a los mismos caracteres que ASCII. Los caracteres de ISO-8859-1 son además los primeros 256 caracteres del estándar Unicode.

La versatilidad de Unicode permite cosas como el uso de emojis como caracteres, que van más allá de los emoticonos, y que los usuarios han adoptado de manera habitual.

Siguiente ->